Что такое технология больших данных?

Как мы знаем, данные постоянно меняются. Рост данных заставил человеческий разум извлекать, анализировать и справляться с этим. Это потому, что традиционные способы работы с данными не поддерживают эти большие данные. Большие данные обычно описываются тремя понятиями: объем, разнообразие и скорость.

Данные теперь стали самым важным активом каждой компании. Анализ этих больших данных помогает компании анализировать поведение своих клиентов и прогнозировать релевантные вещи, связанные с этими решениями, основанными на данных, которые делают организацию, делают более уверенные шаги и создают более сильные стратегии.

Зная, с какими темпами растет объем данных в сегодняшнюю эпоху, в ближайшем будущем большие данные станут гигантским полем для работы. Все студенты, новички, профессионалы будут необходимы, чтобы быть в курсе новейших технологий больших данных. Постоянное информирование о себе принесет большую и успешную карьеру на профессиональном пути.

Технологии больших данных

Здесь я перечисляю несколько технологий больших данных с ясным объяснением, чтобы вы знали о предстоящих тенденциях и технологиях:

-

Apache Spark:

Это быстрый механизм обработки больших данных. Это построено с учетом обработки данных в режиме реального времени. Его богатая библиотека машинного обучения хороша для работы в пространстве ИИ и МЛ. Он обрабатывает данные параллельно и на кластерных компьютерах. Основной тип данных, используемый Spark - это RDD (эластичный распределенный набор данных).

-

Базы данных NoSQL:

Это нереляционные базы данных, которые обеспечивают быстрое хранение и поиск данных. Его способность работать со всеми видами данных, такими как структурированные, полуструктурированные, неструктурированные и полиморфные данные, является уникальной. Нет базы данных SQL следующих типов:

- Базы данных документов : хранит данные в виде документов, которые могут содержать множество различных пар ключ-значение.

- Хранилища графиков . Здесь хранятся данные, которые обычно хранятся в форме сети, например данные социальных сетей.

- Хранилища ключей и значений : это самые простые базы данных NoSQL. Каждый элемент в базе данных хранится как имя атрибута (или «ключ») вместе с его значением.

- Хранилища с широкими столбцами : эта база данных хранит данные в столбчатом формате, а не в формате строк. Кассандра и HBase являются хорошими примерами этого.

-

Апач Кафка:

Kafka - это распределенная платформа потоковой передачи событий, которая ежедневно обрабатывает множество событий. Поскольку это быстро и масштабируемо, это полезно при построении потоковых конвейеров данных в реальном времени, которые надежно выбирают данные между системами или приложениями.

-

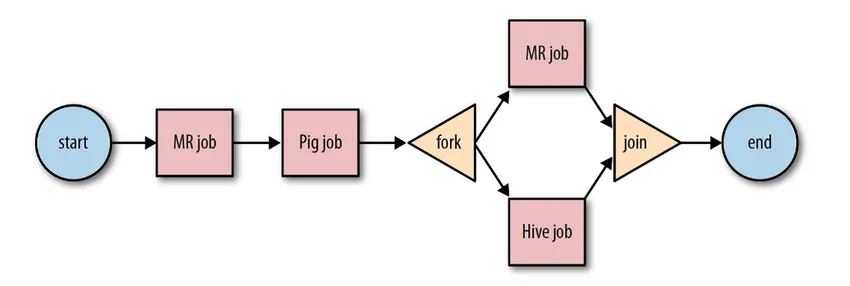

Apache Oozie:

Это система планирования рабочих процессов для управления заданиями Hadoop. Эти рабочие процессы планируются в форме направленных циклических диаграмм (DAG) для действий.

Источник: Google

Это масштабируемое и организованное решение для работы с большими данными.

-

Apache Airflow:

Это платформа, которая планирует и контролирует рабочий процесс. Интеллектуальное планирование помогает организовать эффективное выполнение проекта. Воздушный поток обладает способностью повторно запускать экземпляр DAG при возникновении сбоя. Его богатый пользовательский интерфейс позволяет легко визуализировать конвейеры, работающие на разных этапах, таких как производство, отслеживать прогресс и устранять проблемы при необходимости.

-

Apache Beam:

Это унифицированная модель для определения и выполнения конвейеров обработки данных, которые включают ETL и непрерывную потоковую передачу. Платформа Apache Beam обеспечивает абстракцию между логикой вашего приложения и экосистемой больших данных, поскольку не существует API, связывающего все фреймворки, такие как Hadoop, spark и т. Д.

-

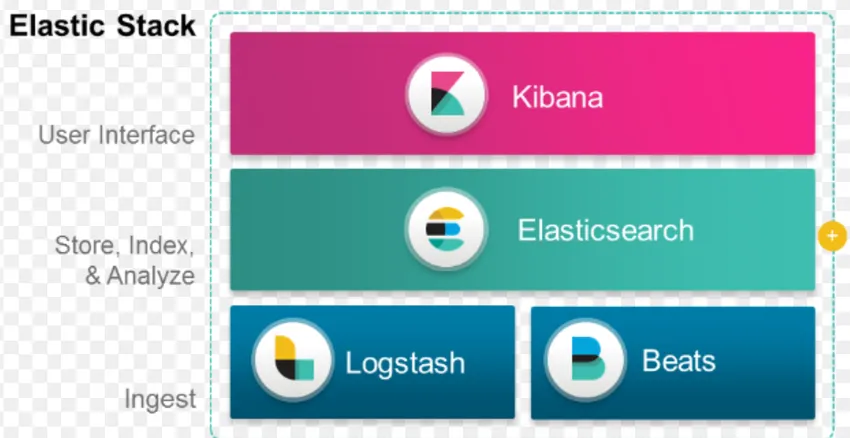

Стек ELK:

ELK известен как Elasticsearch, Logstash и Kibana.

Elasticsearch - это база данных без схемы (которая индексирует каждое поле), которая обладает мощными возможностями поиска и легко масштабируется.

Logstash - это инструмент ETL, который позволяет нам извлекать, преобразовывать и хранить события в Elasticsearch.

Kibana - это инструментальная панель Elasticsearch, где вы можете анализировать все сохраненные данные. Действенные идеи, извлеченные из Kibana, помогают в создании стратегий для организации. От фиксации изменений до прогноза Кибана всегда оказывалась очень полезной.

-

Докер и Куберне:

Это новые технологии, которые помогают приложениям работать в контейнерах Linux. Docker - это набор инструментов с открытым исходным кодом, который поможет вам «собрать, отправить и запустить любое приложение в любом месте».

Kubernetes - это также платформа контейнеров / оркестрований с открытым исходным кодом, позволяющая большому количеству контейнеров работать в гармонии друг с другом. Это в конечном итоге снижает операционную нагрузку.

-

TensorFlow:

Это библиотека машинного обучения с открытым исходным кодом, которая используется для проектирования, создания и обучения моделей глубокого обучения. Все вычисления выполняются в TensorFlow с графиками потока данных. Графики содержат узлы и ребра. Узлы представляют математические операции, а ребра представляют данные.

TensorFlow полезен для исследований и производства. Он был создан с учетом того, что он может работать на нескольких процессорах или графических процессорах и даже мобильных операционных системах. Это может быть реализовано в Python, C ++, R и Java.

-

Presto:

Presto - это SQL-движок с открытым исходным кодом, разработанный Facebook, который способен обрабатывать петабайты данных. В отличие от Hive, Presto не зависит от метода MapReduce и, следовательно, быстрее извлекает данные. Его архитектура и интерфейс достаточно просты для взаимодействия с другими файловыми системами.

Из-за низкой задержки и простого интерактивного запроса в настоящее время он становится очень популярным для обработки больших данных.

-

Polybase:

Polybase работает поверх SQL Server для доступа к данным, хранящимся в PDW (Parallel Data Warehouse). PDW создан для обработки любого объема реляционных данных и обеспечивает интеграцию с Hadoop.

-

Hive:

Hive - это платформа, используемая для запросов и анализа данных в больших наборах данных. Он предоставляет SQL-подобный язык запросов под названием HiveQL, который внутренне преобразуется в MapReduce, а затем обрабатывается.

В связи с быстрым ростом данных и огромным стремлением организации к анализу больших данных, технологии принесли на рынок столько зрелых технологий, что их знание приносит огромную пользу. В настоящее время технология больших данных решает многие бизнес-задачи и проблемы, повышая операционную эффективность и прогнозируя соответствующее поведение. Карьера в области больших данных и связанных с ними технологий может открыть множество возможностей для человека и для бизнеса.

Отныне пришло время внедрять технологии больших данных.

Рекомендуемые статьи

Это было руководство к тому, что такое технология больших данных. Здесь мы обсудили несколько технологий больших данных, таких как Hive, Apache Kafka, Apache Beam, ELK Stack и т. Д. Вы также можете посмотреть следующую статью, чтобы узнать больше -

- Что такое глубокое обучение?

- Руководство по Minitab?

- Что такое технология Salesforce?

- Что такое аналитика больших данных?