Что такое теорема Байеса?

Теорема Байеса - это рецепт, который показывает, как обновить вероятности теорий при наличии доказательств. Он вытекает в основном из принципов условной вероятности, однако его можно использовать для разумного рассуждения по широкому кругу вопросов, включая обновления убеждений.

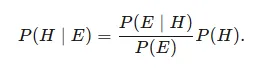

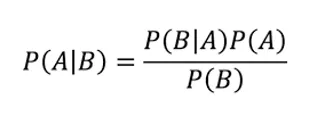

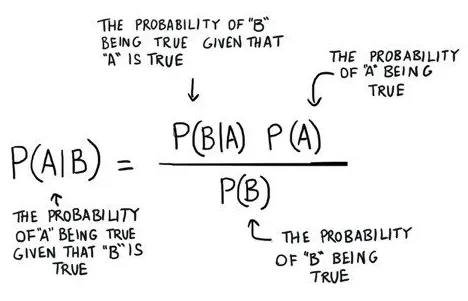

Учитывая теорию H и доказательство E, теорема Байеса выражает, что связь между вероятностью предположения до получения доказательства P (H) и вероятностью теории после получения доказательства P (H∣E)

Это красивая концепция вероятности, где мы находим вероятность, когда мы знаем другую вероятность

Что говорит нам: как часто происходит A, учитывая, что B происходит, состоит P (A | B),

Когда мы знаем: как часто происходит B, учитывая, что происходит An, составляется P (B | A)

кроме того, насколько вероятно, что An без кого-либо еще, состоит P (A)

более того, насколько вероятно, что B без кого-либо еще состоит из P (B)

Пример теоремы Байеса

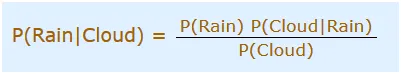

Вы устраиваете сегодня выходной, но утро пасмурное, Бог нам помогает! половина каждого бурного дня начинается с тенистого! В любом случае, тенистые утра являются нормальными (около 40% дней начинаются с облачности). Кроме того, обычно это сухой месяц (обычно 3 из 30 дней будут штормовыми, или 10%). Какова вероятность ливня в течение дня? Мы будем использовать «Дождь» для обозначения ливня в течение дня, а «Облако» для обозначения пасмурного утра. Возможность Дождя с учетом Облака состоит из P (Дождь | Облако)

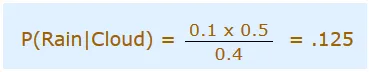

Таким образом, мы должны поместить это в уравнение:

- P (Дождь) Вероятность того, что будет дождь = 10% (Дано)

- P (Облако | Дождь) Вероятность того, что Облака есть, и Дождь случается = 50%

- P (Облако) - Вероятность того, что Облака есть = 40%

Таким образом, мы можем сказать, что в с:

Это теорема Байеса: вы можете использовать вероятность одного, чтобы предвидеть вероятность чего-то другого. Тем не менее, теорема Байеса не является статичной вещью. Это машина, которую вы пытаетесь улучшить и улучшить прогнозы как новые пробные поверхности. Занимательная деятельность заключается в том, чтобы возбудить факторы путем отнесения отличительных теоретических качеств к P (B) или P (A) и рассмотреть их согласованное влияние на P (A | B). Например, если вы увеличиваете знаменатель P (B) справа, в этой точке P (A | B) понижается. Солидная модель: насморк является признаком кори, но насморк, несомненно, более типичен, чем кожная сыпь с небольшими белыми пятнами. То есть, если вы выберете P (B), где B - насморк, в этот момент рецидив насморка у широкой публики снижает вероятность того, что насморк является признаком кори. Вероятность обнаружения кори снижается в отношении побочных эффектов, которые постепенно становятся нормальными; эти проявления не являются твердыми указателями. Точно так же, когда корь становится все более нормальной и P (A) повышается в числителе справа, P (A | B) существенно повышается на том основании, что корь просто более вероятна, не обращая внимания на побочный эффект, который вы считаете.

Использование теоремы Байеса в машинном обучении

Наивный байесовский классификатор

Наивный байесовский расчет - это характеристика для двойных (двухклассовых) и многоклассовых группировок. Система наименее требовательна к пониманию, когда изображена с использованием двойных или прямых информационных качеств.

Это называется наивным байесовским или ненормальным байесовским в свете того факта, что определение вероятностей для каждой теории упрощено, чтобы сделать их подсчитываемыми. В отличие от попыток выяснить оценки каждого признака P (d1, d2, d3 | h), они считаются ограниченно свободными с учетом объективной ценности и определяются как P (d1 | h) * P (d2 | H, и т.п.

Это твердое предположение, которое наиболее неправдоподобно в подлинной информации, например, о том, что свойства не сообщаются. Постепенно, методология работает потрясающе хорошо на информации, где это предположение не выполняется.

Изображение, используемое наивными байесовскими моделями

Изображение наивного алгоритма Байеса - это вероятность.

Множество вероятностей откладывается в петицию за наивно-научную байесовскую модель. Это включает в себя:

Класс Вероятность: вероятность всего в наборе данных подготовки.

Условная вероятность: условная вероятность для каждого экземпляра информации стоит с учетом каждого класса уважения.

Возьмите в наивную байесовскую модель из данных. Извлечение наивной байесовской модели из информации о подготовке происходит быстро. Подготовка выполняется быстро в свете того факта, что должны быть определены значения вероятности для каждого экземпляра класса, и должно быть определено значение вероятности для каждого экземпляра класса с учетом значений отличительной информации (x). Никакие коэффициенты не должны соответствовать системам улучшения.

Определение вероятностей класса

Вероятность класса - это, в основном, повторение случаев, которые имеют место с каждым классом, изолированным полным числом случаев.

Например, в параллельном классе вероятность случая, имеющего место с классом 1, определяется как:

Вероятность (класс = 1) = всего (класс = 1) / (всего (класс = 0) + всего (класс = 1))

В наиболее прямолинейном случае каждый класс, имеющий вероятность 0, 5 или половины для двойной проблемы классификации с одинаковым количеством вхождений в каждом экземпляре класса.

Расчет условной вероятности

Условные вероятности - это повторение оценки каждого признака для данного класса, которое разделено повторением примеров с оценкой этого класса.

Все приложения теоремы Байеса

В действительности существует много применений теоремы Байеса. Постарайтесь не подчеркивать вероятность того, что вы не увидите сразу всю арифметику. Для начала достаточно просто почувствовать, как он функционирует.

Байесовская теория принятия решений является измеримым способом решения проблемы классификации примеров. Согласно этой гипотезе, ожидается, что базовая вероятность передачи для классов известна. Таким образом, мы получаем совершенный байесовский классификатор, в отношении которого любой другой классификатор принимает решение об исполнении.

Мы поговорим о трех основных применениях теоремы Байеса:

- Наивный байесовский классификатор

- Дискриминантные функции и поверхности принятия решений

- Байесовская оценка параметров

Вывод

Великолепие и интенсивность теоремы Байеса никогда не перестанут меня удивлять. Основная идея, выдвинутая священником, ушедшим более 250 лет назад, сегодня находит свое применение в абсолютно безошибочных процедурах ИИ.

Рекомендуемые статьи

Это руководство к теореме Байеса. Здесь мы обсуждаем использование теоремы Байеса в машинном обучении и изображение, используемое наивными байесовскими моделями, с примерами. Вы также можете взглянуть на следующие статьи, чтобы узнать больше -

- Наивный байесовский алгоритм

- Типы алгоритмов машинного обучения

- Модели машинного обучения

- Методы машинного обучения