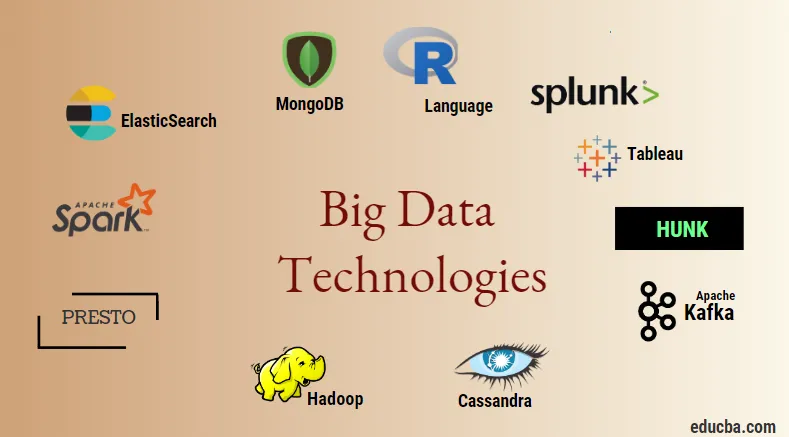

Введение в технологии больших данных

Технология больших данных, и Hadoop - это громкое модное слово. Поскольку объем данных и информации в каждой отрасли и области значительно увеличился, становится очень важно разработать и внедрить эффективную методику, которая учитывает все потребности и требования клиентов и крупных отраслей, отвечающих за генерацию данных., Раньше данные обрабатывались обычными языками программирования и простым языком структурированных запросов, но теперь эти системы и инструменты, кажется, мало что делают в случае больших данных. Технология больших данных определяется как технология и программная утилита, предназначенная для анализа, обработки и извлечения информации из большого набора чрезвычайно сложной структуры и больших наборов данных, с которыми очень трудно иметь дело в традиционных системах. Технология больших данных используется для обработки данных как в режиме реального времени, так и в пакетном режиме. Машинное обучение стало очень важным компонентом повседневной жизни и каждой отрасли, и поэтому управление данными с помощью больших данных становится очень важным.

Типы технологий больших данных

Прежде чем начать со списка технологий, давайте сначала рассмотрим широкую классификацию всех этих технологий. Их можно в основном классифицировать на 4 домена.

- Хранилище данных

- аналитика

- Сбор данных

- Визуализация

Давайте сначала рассмотрим все технологии, которые находятся под зонтиком хранения.

1. Hadoop : когда речь идет о больших данных, Hadoop является первой технологией, которая вступает в игру. Это основано на архитектуре сокращения карт и помогает в обработке заданий, связанных с партиями, и обработке информации о партиях. Он был разработан для хранения и обработки данных в распределенной среде обработки данных наряду с обычным аппаратным обеспечением и простой моделью выполнения программирования. Его можно использовать для хранения и анализа данных, представленных на различных компьютерах, с высокой скоростью хранения и низкой стоимостью. Это является одним из основных компонентов технологии больших данных, которая была разработана программным фондом Apache в 2011 году и написана на Java.

1. Hadoop : когда речь идет о больших данных, Hadoop является первой технологией, которая вступает в игру. Это основано на архитектуре сокращения карт и помогает в обработке заданий, связанных с партиями, и обработке информации о партиях. Он был разработан для хранения и обработки данных в распределенной среде обработки данных наряду с обычным аппаратным обеспечением и простой моделью выполнения программирования. Его можно использовать для хранения и анализа данных, представленных на различных компьютерах, с высокой скоростью хранения и низкой стоимостью. Это является одним из основных компонентов технологии больших данных, которая была разработана программным фондом Apache в 2011 году и написана на Java.

2. MongoDB . Другой очень важный и ключевой компонент технологии больших данных с точки зрения хранения - это база данных MongoDB NoSQL. Это база данных NoSQL, которая означает, что реляционные свойства и другие связанные с СУБД свойства не применяются к ней. Он отличается от традиционных баз данных СУБД, в которых используется язык структурированных запросов. Он использует документы схемы, и структура хранения данных также отличается, и поэтому они полезны для хранения большого количества данных. Это кроссплатформенная документально-ориентированная программа проектирования и базы данных, которая использует JSON-подобные документы вместе со схемой. Это становится очень полезным примером использования хранилищ оперативных данных в большинстве финансовых учреждений и, таким образом, работает над заменой традиционных мейнфреймов. MongoDB поддерживает гибкость, а также широкий спектр типов данных в больших объемах и среди распределенных архитектур.

2. MongoDB . Другой очень важный и ключевой компонент технологии больших данных с точки зрения хранения - это база данных MongoDB NoSQL. Это база данных NoSQL, которая означает, что реляционные свойства и другие связанные с СУБД свойства не применяются к ней. Он отличается от традиционных баз данных СУБД, в которых используется язык структурированных запросов. Он использует документы схемы, и структура хранения данных также отличается, и поэтому они полезны для хранения большого количества данных. Это кроссплатформенная документально-ориентированная программа проектирования и базы данных, которая использует JSON-подобные документы вместе со схемой. Это становится очень полезным примером использования хранилищ оперативных данных в большинстве финансовых учреждений и, таким образом, работает над заменой традиционных мейнфреймов. MongoDB поддерживает гибкость, а также широкий спектр типов данных в больших объемах и среди распределенных архитектур.

3. Блок : Полезно для доступа к данным через удаленные кластеры Hadoop, используя виртуальные индексы, а также использует язык обработки поиска Splunk, который можно использовать для анализа данных. Блок может использоваться для создания отчетов и визуализации огромных объемов данных из баз данных и источников Hadoop и NoSQL. Он был разработан командой Splunk в 2013 году, который был написан на Java.

3. Блок : Полезно для доступа к данным через удаленные кластеры Hadoop, используя виртуальные индексы, а также использует язык обработки поиска Splunk, который можно использовать для анализа данных. Блок может использоваться для создания отчетов и визуализации огромных объемов данных из баз данных и источников Hadoop и NoSQL. Он был разработан командой Splunk в 2013 году, который был написан на Java.

4. Cassandra : Cassandra формирует лучший выбор среди списка популярных баз данных NoSQL, который представляет собой бесплатную базу данных с открытым исходным кодом, которая распространяется и имеет широкое столбцовое хранилище и может эффективно обрабатывать данные в крупных товарных кластерах, т.е. она используется для обеспечить высокую доступность без единой точки отказа. В список основных функций входят такие, как распределенная природа, масштабируемость, отказоустойчивый механизм, поддержка MapReduce, настраиваемая согласованность, свойство языка запросов, поддержка репликации нескольких центров обработки данных и возможная согласованность.

4. Cassandra : Cassandra формирует лучший выбор среди списка популярных баз данных NoSQL, который представляет собой бесплатную базу данных с открытым исходным кодом, которая распространяется и имеет широкое столбцовое хранилище и может эффективно обрабатывать данные в крупных товарных кластерах, т.е. она используется для обеспечить высокую доступность без единой точки отказа. В список основных функций входят такие, как распределенная природа, масштабируемость, отказоустойчивый механизм, поддержка MapReduce, настраиваемая согласованность, свойство языка запросов, поддержка репликации нескольких центров обработки данных и возможная согласованность.

Далее давайте поговорим о различных областях технологии больших данных, например Data Mining.

5. Presto : это популярный механизм распределенных запросов с открытым исходным кодом и SQL, который используется для выполнения интерактивных запросов к источникам данных любого масштаба и размерами от гигабайтов до петабайтов. С его помощью мы можем запрашивать данные в Cassandra, Hive, проприетарных хранилищах данных и системах хранения реляционных баз данных. Это механизм обработки запросов на основе Java, разработанный фондом Apache в 2013 году. Несколько компаний, которые эффективно используют инструмент Presto, - это Netflix, Airbnb, Checkr, Repro и facebook.

5. Presto : это популярный механизм распределенных запросов с открытым исходным кодом и SQL, который используется для выполнения интерактивных запросов к источникам данных любого масштаба и размерами от гигабайтов до петабайтов. С его помощью мы можем запрашивать данные в Cassandra, Hive, проприетарных хранилищах данных и системах хранения реляционных баз данных. Это механизм обработки запросов на основе Java, разработанный фондом Apache в 2013 году. Несколько компаний, которые эффективно используют инструмент Presto, - это Netflix, Airbnb, Checkr, Repro и facebook.

6. ElasticSearch : это очень важный инструмент сегодня, когда речь идет о поиске. Это формирует существенный компонент стека ELK, то есть упругий поиск, Logstash и Kibana. ElasticSearch - это поисковая система на основе библиотеки Lucene, которая похожа на Solr и используется для предоставления чисто распределенной, полнотекстовой поисковой системы, способной работать с несколькими арендаторами. Он содержит список документов JSON без схемы и веб-интерфейс HTTP. Он написан на языке JAVA и разработан компанией Elastic в компании 2012. Названия нескольких компаний, использующих эластичный поиск: LinkedIn, StackOverflow, Netflix, facebook, Google, Accenture и т. Д.

6. ElasticSearch : это очень важный инструмент сегодня, когда речь идет о поиске. Это формирует существенный компонент стека ELK, то есть упругий поиск, Logstash и Kibana. ElasticSearch - это поисковая система на основе библиотеки Lucene, которая похожа на Solr и используется для предоставления чисто распределенной, полнотекстовой поисковой системы, способной работать с несколькими арендаторами. Он содержит список документов JSON без схемы и веб-интерфейс HTTP. Он написан на языке JAVA и разработан компанией Elastic в компании 2012. Названия нескольких компаний, использующих эластичный поиск: LinkedIn, StackOverflow, Netflix, facebook, Google, Accenture и т. Д.

Теперь давайте прочитаем обо всех тех технологиях больших данных, которые являются частью анализа данных:

7. Apache Kafka . Известен своей системой публикации-подписки или публикации-подписки, известной как «посредник по асинхронному обмену сообщениями», который используется для приема и обработки данных в потоковом режиме в реальном времени. Это также обеспечивает предоставление периода хранения, и данные могут быть направлены с помощью механизма производителя-потребителя. Это одна из самых популярных потоковых платформ, которая очень похожа на корпоративную систему обмена сообщениями или очередь сообщений. На сегодняшний день Kafka выпустила множество улучшений, и одним из основных видов является Kafka confluent, который обеспечивает дополнительный уровень свойств для Kafka, таких как реестр Schema, Ktables, KSql и т. Д. Он был разработан сообществом Apache Software в 2011 году и написано на Java. Компании, использующие эту технологию, включают в себя Twitter, Spotify, Netflix, Linkedin, Yahoo и т. Д.

7. Apache Kafka . Известен своей системой публикации-подписки или публикации-подписки, известной как «посредник по асинхронному обмену сообщениями», который используется для приема и обработки данных в потоковом режиме в реальном времени. Это также обеспечивает предоставление периода хранения, и данные могут быть направлены с помощью механизма производителя-потребителя. Это одна из самых популярных потоковых платформ, которая очень похожа на корпоративную систему обмена сообщениями или очередь сообщений. На сегодняшний день Kafka выпустила множество улучшений, и одним из основных видов является Kafka confluent, который обеспечивает дополнительный уровень свойств для Kafka, таких как реестр Schema, Ktables, KSql и т. Д. Он был разработан сообществом Apache Software в 2011 году и написано на Java. Компании, использующие эту технологию, включают в себя Twitter, Spotify, Netflix, Linkedin, Yahoo и т. Д.

8. Splunk : Splunk используется для сбора, корреляции и индексации потоковых данных в реальном времени из доступного для поиска хранилища, из которого он может генерировать отчеты, графики, информационные панели, оповещения и визуализации данных. Он также используется для обеспечения безопасности, соответствия и управления приложениями, а также для веб-аналитики, создания бизнес-аналитики и бизнес-анализа. Он был разработан Splunk на Python, XML, Ajax.

8. Splunk : Splunk используется для сбора, корреляции и индексации потоковых данных в реальном времени из доступного для поиска хранилища, из которого он может генерировать отчеты, графики, информационные панели, оповещения и визуализации данных. Он также используется для обеспечения безопасности, соответствия и управления приложениями, а также для веб-аналитики, создания бизнес-аналитики и бизнес-анализа. Он был разработан Splunk на Python, XML, Ajax.

9. Apache Spark . Теперь появилась самая критическая и наиболее ожидаемая технология в области технологий больших данных, то есть Apache Spark. Возможно, он является одним из тех, которые наиболее востребованы сегодня, и использует для его обработки Java, Scala или Python. Это используется для обработки и обработки потоковых данных в реальном времени, используя Spark Streaming, которая использует для этого операции пакетной обработки и управления окнами. Spark SQL используется для создания фреймов данных, наборов данных поверх RDD и, таким образом, обеспечивает хороший вид преобразований и действий, которые составляют неотъемлемый компонент Apache Spark Core. Другие компоненты, такие как Spark Mllib, R и graphX, также полезны в случае анализа и машинного обучения и обработки данных. Техника вычислений в памяти - это то, что отличает ее от других инструментов и компонентов и поддерживает широкий спектр приложений. Он был разработан фондом Apache Software в первую очередь на языке Java.

9. Apache Spark . Теперь появилась самая критическая и наиболее ожидаемая технология в области технологий больших данных, то есть Apache Spark. Возможно, он является одним из тех, которые наиболее востребованы сегодня, и использует для его обработки Java, Scala или Python. Это используется для обработки и обработки потоковых данных в реальном времени, используя Spark Streaming, которая использует для этого операции пакетной обработки и управления окнами. Spark SQL используется для создания фреймов данных, наборов данных поверх RDD и, таким образом, обеспечивает хороший вид преобразований и действий, которые составляют неотъемлемый компонент Apache Spark Core. Другие компоненты, такие как Spark Mllib, R и graphX, также полезны в случае анализа и машинного обучения и обработки данных. Техника вычислений в памяти - это то, что отличает ее от других инструментов и компонентов и поддерживает широкий спектр приложений. Он был разработан фондом Apache Software в первую очередь на языке Java.

10. Язык R : R - это язык программирования и среда свободного программного обеспечения, которая используется для статистических вычислений, а также для графики на одном из самых важных языков в R. Это один из самых популярных языков среди исследователей данных, майнеров данных и практиков данных для разработки статистического программного обеспечения и в основном в области анализа данных.

10. Язык R : R - это язык программирования и среда свободного программного обеспечения, которая используется для статистических вычислений, а также для графики на одном из самых важных языков в R. Это один из самых популярных языков среди исследователей данных, майнеров данных и практиков данных для разработки статистического программного обеспечения и в основном в области анализа данных.

Давайте теперь обсудим технологии, связанные с визуализацией данных.

11. Tableau: это самый быстрый и мощный растущий инструмент визуализации данных, который используется в сфере бизнес-аналитики. Анализ данных - это очень быстрая машина, которая возможна с помощью Таблицы, и визуализации создаются в форме Рабочих листов и информационных панелей. Он разработан компанией tableau в 2013 году и написан на Python, C ++, Java и C. Компаниями, использующими Tableau, являются: QlikQ, Oracle Hyperion, Cognos и т. Д.

11. Tableau: это самый быстрый и мощный растущий инструмент визуализации данных, который используется в сфере бизнес-аналитики. Анализ данных - это очень быстрая машина, которая возможна с помощью Таблицы, и визуализации создаются в форме Рабочих листов и информационных панелей. Он разработан компанией tableau в 2013 году и написан на Python, C ++, Java и C. Компаниями, использующими Tableau, являются: QlikQ, Oracle Hyperion, Cognos и т. Д.

12. Plotly : Plotly в основном используется для ускорения и повышения эффективности графиков и связанных с ними компонентов. Он имеет более богатый набор библиотек и API-интерфейсов, таких как MATLAB, Python, R, Arduino, Julia и т. Д. Это можно использовать в интерактивном режиме в блокноте Jupyter и Pycharm, а также для стилизации интерактивных графов. Впервые он был разработан в 2012 году и написан на JavaScript. Те немногие компании, которые используют Plotly - это паладины, битбанки и т. Д.

12. Plotly : Plotly в основном используется для ускорения и повышения эффективности графиков и связанных с ними компонентов. Он имеет более богатый набор библиотек и API-интерфейсов, таких как MATLAB, Python, R, Arduino, Julia и т. Д. Это можно использовать в интерактивном режиме в блокноте Jupyter и Pycharm, а также для стилизации интерактивных графов. Впервые он был разработан в 2012 году и написан на JavaScript. Те немногие компании, которые используют Plotly - это паладины, битбанки и т. Д.

Вывод

В этом посте мы изучили основные технологии больших данных, которые широко используются сегодня. Надеюсь, вам понравилось. Следите за нами для получения новых сообщений, подобных этим.

Рекомендуемые статьи

Это руководство по технологиям больших данных. Здесь мы обсудим введение и типы технологий больших данных. Вы также можете просмотреть наши другие предлагаемые статьи, чтобы узнать больше -

- Что такое Splunk Tool?

- R против Python

- Что такое Matlab?

- Что такое MongoDB?

- Шаги, которые необходимо выполнить при тестировании мэйнфреймов

- Типы объединений в Spark SQL (примеры)

- Изучите различные типы инструментов Кафки