Что такое НЛП в Python?

Искусственный интеллект значительно развился за последнее десятилетие, как и одно из его подразделов - обработка естественного языка. Прогресс в области ИИ является результатом огромной вычислительной мощности современных систем и больших объемов неструктурированных данных, которые генерируются из множества источников. Natural Language Processing или NLP - это исследование искусственного интеллекта, которое позволяет компьютерам обрабатывать необработанные неструктурированные текстовые данные и извлекать из них скрытые данные.

Определение

В отличие от людей, компьютеры недостаточно умны для обработки неструктурированных данных. Люди могут получать значения из таких данных, в то время как компьютеры могут делать это только с помощью структурированных данных, хранящихся в базах данных. Чтобы находить закономерности и извлекать смысл из естественных данных, компьютеры используют инструменты и методы, используемые в НЛП, для обработки таких данных.

Как НЛП работает в Python?

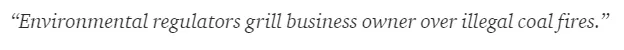

Очень сложно читать и понимать по-английски. Приведенное ниже предложение является одним из таких примеров, когда компьютеру действительно сложно понять реальную мысль, стоящую за предложением.

В машинном обучении строится конвейер для каждой проблемы, где каждая часть проблемы решается отдельно с использованием ML. Конечным результатом будет сочетание нескольких моделей машинного обучения, соединенных вместе. Обработка естественного языка работает аналогично тому, как английское предложение делится на куски.

В этом параграфе есть несколько фактов. Все было бы легко, если бы сами компьютеры могли понять, что такое Лондон, но для этого компьютеры должны быть обучены основам письменного языка.

1. Сегментация предложения - корпус разбит на несколько предложений, как показано ниже.

Это облегчит нашу жизнь, так как лучше обрабатывать одно предложение, чем целый абзац. Разделение может быть выполнено на основе знаков препинания или нескольких других сложных методов, которые также работают с неочищенными данными.

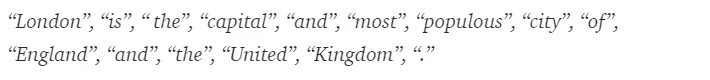

2. Слово токенизация - предложение может быть далее разделено на токен слов, как показано ниже.

После токенизации вышеприведенное предложение делится на:

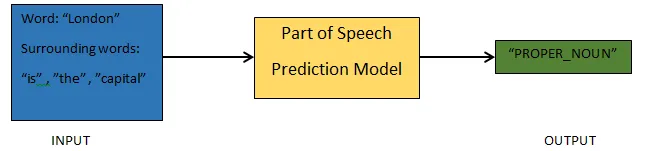

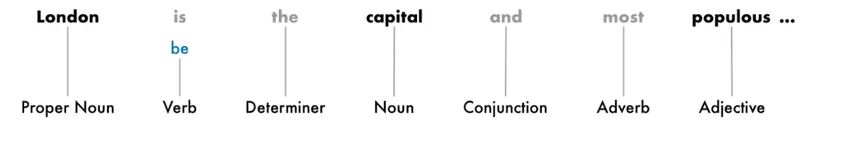

3. Части предсказания речи. Этот процесс предназначен для создания частей речи для каждого токена. Это позволило бы нам понять значение предложения и тему, о которой говорится в предложении.

4. Лемматизация . Слово в предложении может появляться в разных формах. Лемматизация отслеживает слово до его корня, т. Е. Лемму каждого слова.

5. Остановить идентификацию слов. В предложении много слов-наполнителей, таких как «the», «a». Эти слова действуют как шум в тексте, значение которого мы пытаемся извлечь. Таким образом, необходимо отфильтровать эти стоп-слова, чтобы построить лучшую модель.

В зависимости от приложения, стоп-слова могут отличаться. Тем не менее, существует заранее определенный список остановок, на которые можно сослаться.

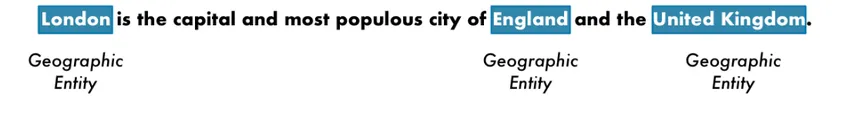

6. Распознавание именованных сущностей - NER - это процесс поиска сущностей, таких как имя, место, личность, организация и т. Д., Из предложения.

Здесь используется контекст появления слова в предложении. Для извлечения структурированных данных из текста у систем NER есть много применений.

Пример НЛП в Python

Большинство компаний теперь готовы обрабатывать неструктурированные данные для роста своего бизнеса. НЛП имеет широкий спектр применения, и наиболее распространенным вариантом использования является классификация текста.

Классификация текста по различным категориям автоматически называется классификацией текста. Обнаружение спама или нежелательной почты в электронной почте, классификация новостных статей - вот некоторые из распространенных примеров классификации текста. Данные, используемые для этой цели, должны быть помечены.

Вот несколько шагов в конвейере классификации текста, которые необходимо выполнить:

- Загрузка и предварительная обработка данных - это первый шаг, а затем он будет разбит на последовательность и набор проверок.

- Этап Feature Feature включает извлечение полезных функций или создание дополнительных значимых функций, которые помогут в разработке более совершенной модели прогнозирования.

- Чтобы построить модель, для обучения модели используется помеченный набор данных.

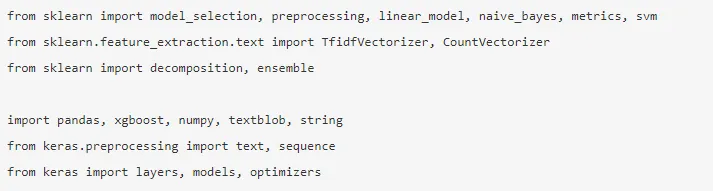

Pandas, Scikit-learn, XGBoost, TextBlog, Keras - это лишь некоторые из необходимых библиотек, которые нам нужно установить. Затем мы импортируем библиотеки для подготовки набора данных, разработки функций и т. Д.

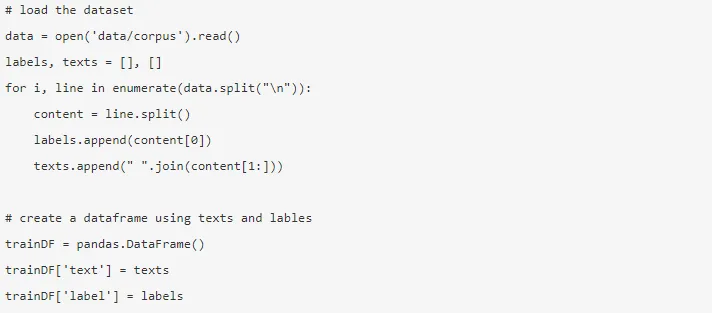

Данные огромны, почти 3, 6 миллиона отзывов можно скачать здесь. Часть данных используется. Это загрузка и чтение в фрейм данных Pandas.

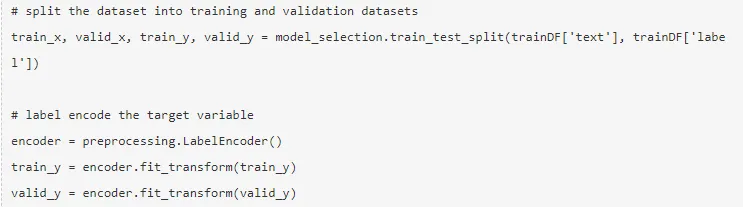

Целевая переменная кодируется, и данные разбиваются на последовательность и наборы тестов.

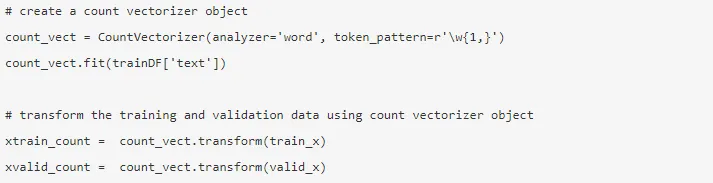

Функциональное проектирование выполняется с использованием следующих различных методов.

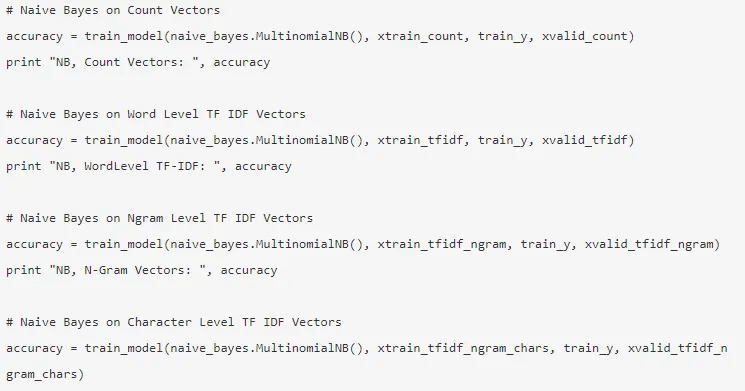

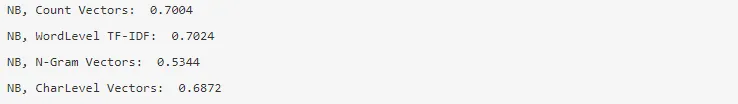

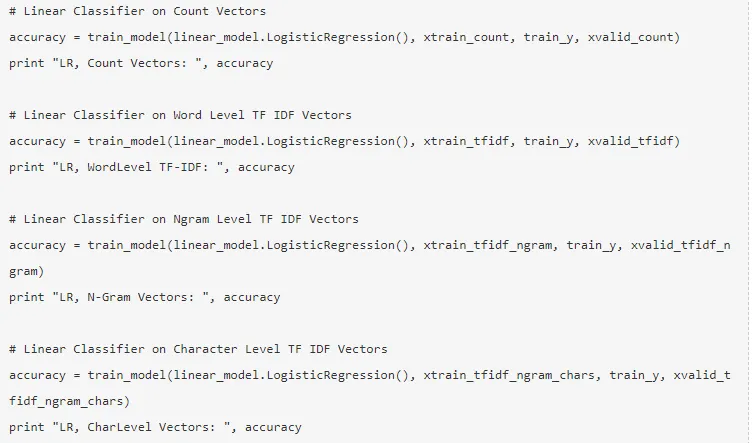

1. Подсчет векторов . Представление документа, термина и его частоты из корпуса достигается с помощью векторов подсчета.

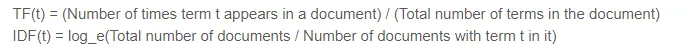

2. Векторы TF-IDF - В документе относительная важность термина представлена частотой термина (TF) и показателем частоты обратного документа (IDF). TF-IDF можно рассчитать по:

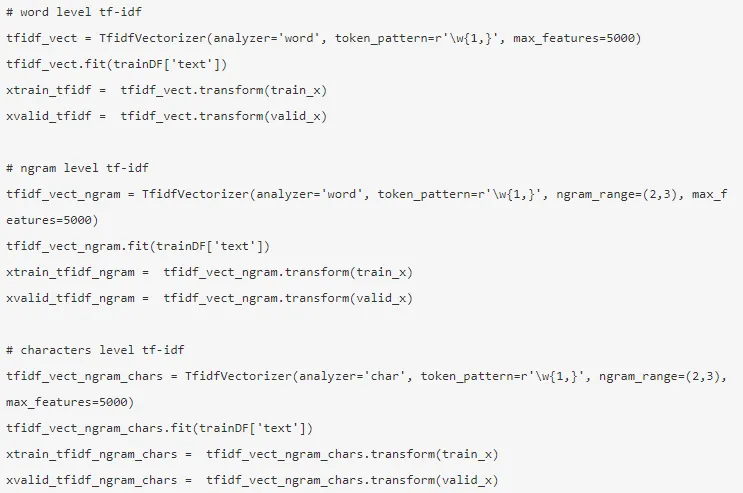

Векторы TF-IDF могут быть сгенерированы на уровне Word, который представляет оценку каждого термина, и на уровне N-граммы, который является комбинацией n-терминов.

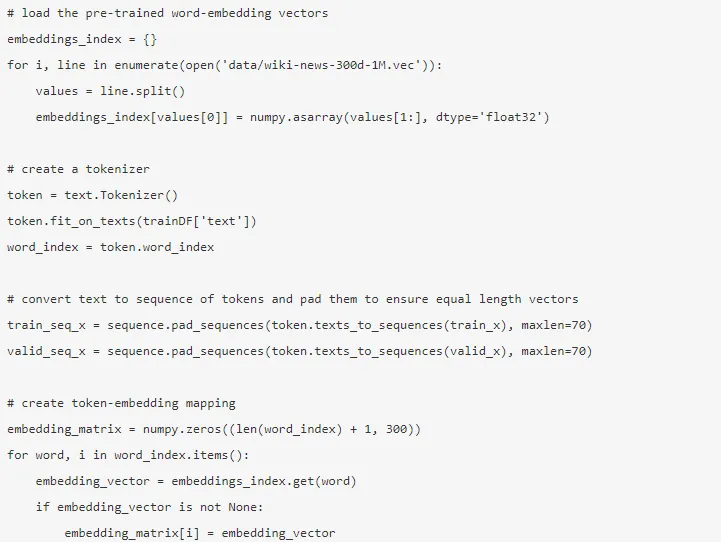

3. Вложение слов . Представление документов и слов в виде плотного вектора известно как вложение слов. Существуют предварительно обученные встраивания, такие как Glove, Word2Vec, которые можно использовать или обучать.

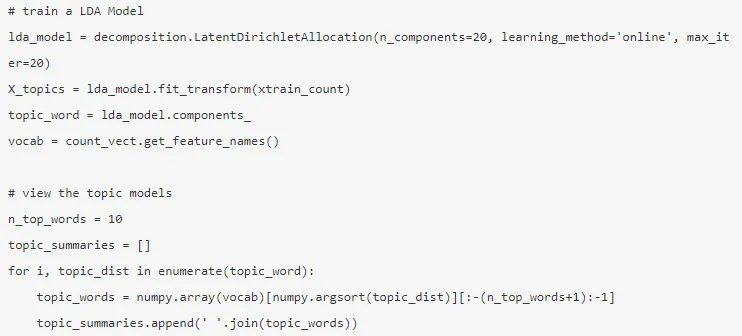

4. Тематические модели - это группа слов из документа, которая несет наибольшую информацию. Скрытое распределение Дирихле используется здесь для тематического моделирования.

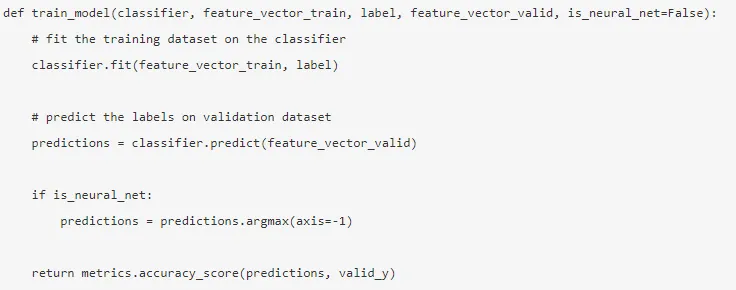

Режим создается после того, как разработка функций завершена, и соответствующие функции были извлечены.

5. Наивный байесовский метод. Он основан на теореме Байеса, и алгоритм считает, что между функциями в наборе данных нет никакой связи.

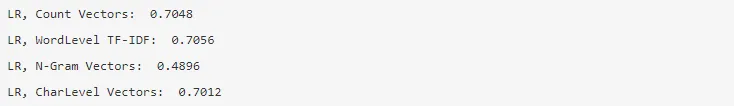

6. Логистическая регрессия - она измеряет линейную зависимость между признаками, а целевая переменная измеряется на основе сигмоидальной функции, которая оценивает вероятности.

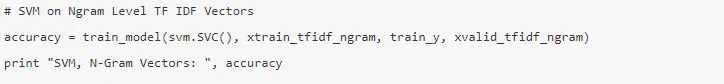

7. Машина опорных векторов . Гиперплоскость разделяет два класса в SVM.

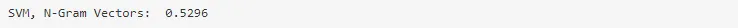

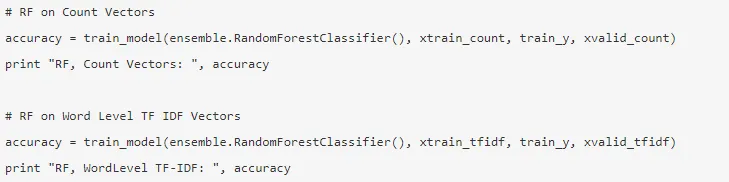

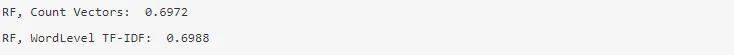

8. Модель случайного леса - модель ансамбля, в которой уменьшается дисперсия и объединяются несколько деревьев решений.

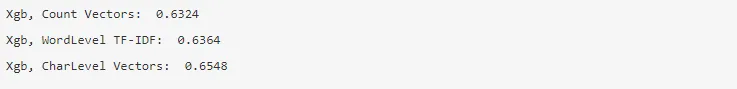

9. XG Boost - Смещение уменьшается, и слабые ученики превращаются в сильных.

Как НЛП поможет вам в вашей карьере?

Обработка естественного языка - быстро развивающаяся область на рынке, и почти каждой организации нужен инженер НЛП, чтобы помочь им обрабатывать необработанные данные. Таким образом, необходимо овладеть необходимыми навыками, поскольку на рынке не будет недостатка в рабочих местах.

Вывод: НЛП в Python

В этой статье мы начали с введения в NLP в Python, а затем реализовали один сценарий использования в Python, чтобы показать, как работать с NLP в Python.

Рекомендуемые статьи

Это было руководство для НЛП в Python. Здесь мы обсудили Пример, Варианты использования и как работать с NLP в Python. Вы также можете просмотреть наши другие предлагаемые статьи, чтобы узнать больше -

- Использование Python

- Что такое WBS?

- Python против Scala

- Что такое таблица?