Введение в Hadoop fs Commands

В этой статье мы рассмотрим команды обработки файлов HADOOP, который используется для управления файлами через консоль.

Вам понадобится система Linux и последняя версия Hadoop. Чтобы напечатать версию Hadoop, чтобы узнать, кем был выпущен релиз, нужно ввести значение контрольной суммы, нам просто нужно выполнить приведенную ниже команду после входа в платформу Hadoop.

Команда: версия Hadoop

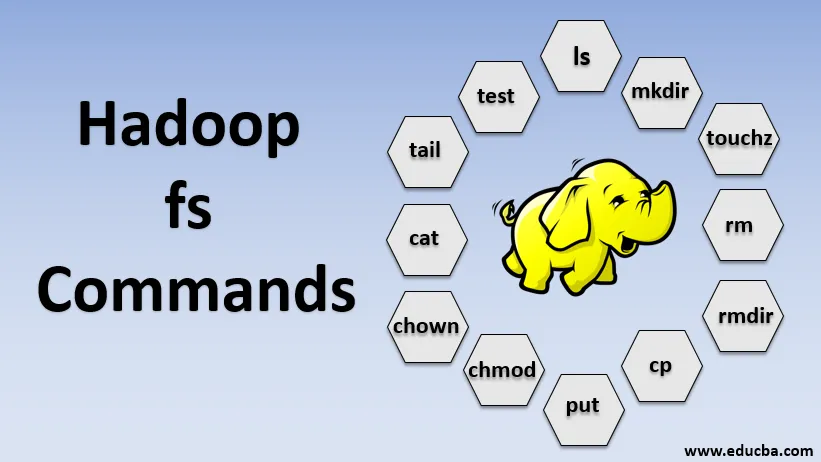

Команды Hadoop fs

Теперь давайте узнаем, как использовать команды HADOOP fs.

Начнем с основ. Просто введите эти команды в PUTTY или любой консоли, с которой вам удобно.

1. hadoop fs -ls

Для каталога он возвращает список файлов и каталогов, тогда как для файла он возвращает статистику по файлу.

hadoop fs -lsr: это для рекурсивного перечисления каталогов и файлов в определенных папках.

- Пример : hadoop fs -ls / или hadoop fs -lsr

- -d: используется для вывода каталогов в виде простых файлов.

- -h: Используется для форматирования размеров файлов в удобочитаемом виде, а не только в количестве байтов.

- -R: это используется для рекурсивного перечисления содержимого каталогов.

2. hadoop fs -mkdir

Эта команда принимает путь в качестве аргумента и создает каталоги в формате hdf.

- Пример : hadoop fs -mkdir / user / datahub1 / data

3. hadoop fs -touchz

Создает пустой файл и не использует места

- Пример: hadoop fs -touchz URI

4. hadoop fs -rm

Удалить файлы, указанные в качестве аргумента. Мы должны указать опцию -r, чтобы удалить весь каталог. И если указана опция -skipTrash, она пропустит корзину и файл будет немедленно удален.

- Пример : hadoop fs -rm -r /user/test1/abc.text

5. hadoopfs -rmdir

Он удаляет файлы и разрешения каталогов и подкаталогов. По сути это расширенная версия Hadoop fs -rm.

6. hadoop fs -cp

Копирует файл из одного места в другое

- Пример : hadoop fs -cp /user/data/abc.csv / user / datahub

7. hadoop fs -copyFromLocal

Копирует файл из edgenode в HDFS.

8. hadoop fs -put

Он копирует файл из edgenode в HDFS, он аналогичен предыдущей команде, но помещает также читает ввод из стандартного ввода stdin и записывает в HDFS

- Пример : hadoop fs -put abc.csv / user / data

hadoop fs -put -p: флаг сохраняет доступ, время модификации, владельца и режим.

hadoop fs -put -f: эта команда перезаписывает место назначения, если файл уже существует до копирования.

9. hadoop fs -moveFromLocal

Это похоже на локальное копирование, за исключением того, что исходный файл удаляется из локального edgenode после его копирования в HDFS.

- Пример : fs -moveFromLocal abc.text / user / data / acb.

10. hadoop fs -copyToLocal

Копирует файл из HDFS в edgenode.

- Пример : fs -copyToLocal abc.text / localpath

11. hadoop fs -chmod

Эта команда помогает нам изменить доступ к файлу или каталогу

- Пример : hadoop fs -chmod (-R) (путь)

12. hadoop fs -chown

Эта команда помогает нам изменить владельца файла или каталога

- Пример : hadoop fs -chown (-R) (OWNER) (:( GROUP)) PATH

13. hadoop fs -cat

Он печатает содержимое файла HDFS на терминале

- Пример : hadoop fs -cat /user/data/abc.csv

14. hadoop fs -tail

Он отображает последний килобайт файла HDFS на стандартный вывод

- Пример : hadoop fs -tail / in / xyzfile

15. hadoop fs -test

Эта команда используется для операций тестирования файлов HDFS, она возвращает 0, если истина.

- - e: проверяет, существует ли файл.

- -z: проверяет, является ли файл нулевой длины

- -d / -f: проверяет, является ли путь каталогом / файлом соответственно

Здесь мы подробно обсудим пример

- Пример : hadoop fs -test - (defz) /user/test/test1.text

16. hadoop fs -du

Отображает размеры файлов и каталогов, содержащихся в данном каталоге, или длину файла, если это файл

17. hadoop fs -df

Отображает свободное место

18. hadoop fs -checksum

Возвращает информацию о контрольной сумме файла

19. hadoop fs -getfacl

Он отображает список контроля доступа (ACL) конкретного файла или каталога

20. hadoop fs -count

Он подсчитывает количество каталогов, файлов и байтов по пути, соответствующему указанному шаблону файла.

21. hadoop fs -setrep

Изменяет коэффициент репликации файла. И если путь является каталогом, то команда изменяет коэффициент репликации всех файлов в каталоге.

- Пример : hadoop fs -setrep -R / user / datahub: он используется для принятия обратной возможности и не имеет никакого эффекта.

hadoop fs - setrep -w / user / datahub : ожидает завершения репликации

22. hadoop fs -getmerge

Он объединяет файлы HDFS в источнике в локальный файл назначения

- Пример : hadoop fs -getmerge / user / datahub

23. hadoop fs -appendToFile

Добавляет один или несколько источников из локальной файловой системы в место назначения.

- Пример : hadoop fs -appendToFile xyz.log data.csv / in / appendfile

24. hadoop fs -stat

Он печатает статистику о файле или каталоге.

- Пример : hadoop fs -stat (формат)

Вывод - Hadoop fs Commands

Итак, мы прошли почти все команды, которые необходимы для обработки файлов и просмотра данных внутри файлов. Теперь вы можете изменять свои файлы и загружать данные в платформу Hadoop.

Рекомендуемые статьи

Это руководство по командам Hadoop fs. Здесь мы подробно обсудим введение в команды Hadoop fs и его пример. Вы также можете посмотреть следующие статьи, чтобы узнать больше

- Установить Hadoop

- Инструменты Hadoop

- Hadoop Architecture

- Компоненты Hadoop

- Команды Hadoop fs