Введение в алгоритмы классификации

В этой статье об алгоритмах классификации дается обзор различных методов классификации, обычно используемых в методах интеллектуального анализа данных с различными принципами. Классификация - это метод, который классифицирует данные на различное количество классов и, в свою очередь, присваивает метки каждому классу. Основная цель классификации - определить класс для запуска новых данных путем анализа обучающего набора, увидев надлежащие границы. В общем случае прогнозирование целевого класса и описанного выше процесса называется классификацией.

Например, руководство больницы записывает имя пациента, адрес, возраст, предыдущую историю здоровья пациента, чтобы диагностировать их, это помогает классифицировать пациентов. Их можно разделить на два этапа: этап обучения и этап оценки. Фаза обучения моделирует базу подхода и включает в себя обучающие данные, тогда как фаза оценки прогнозирует выходные данные для данных. Мы могли бы найти их приложения в спаме по электронной почте, прогнозе банковского кредита, распознавании речи, анализе настроений. Методика включает в себя математическую функцию f с входом X и выходом Y.

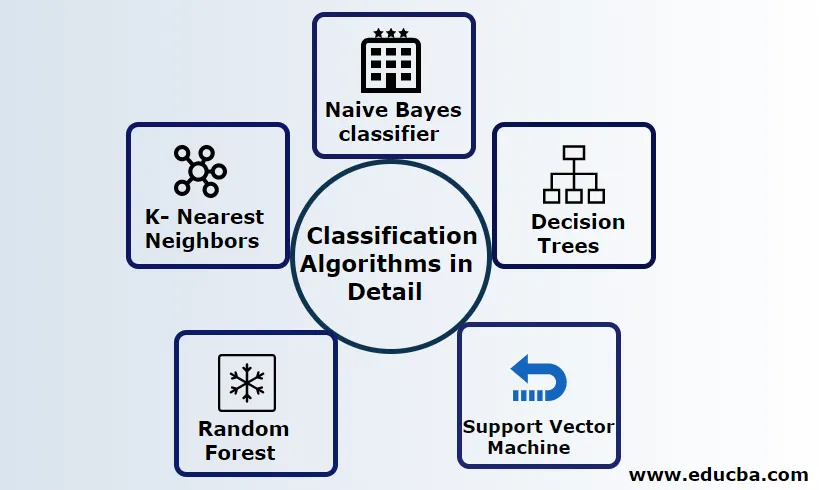

Подробно объяснить алгоритмы классификации

Классификация может быть выполнена как на структурированных, так и на неструктурированных данных. Классификация может быть разделена на

- Наивный байесовский классификатор

- Деревья решений

- Машина опорных векторов

- Случайный Лес

- K- Ближайшие соседи

1) Наивный байесовский классификатор

Это алгоритм, основанный на теоремах Байеса, одна из статистических классификаций, требующая небольшого количества обучающих данных для оценки параметров, также известных как вероятностные классификаторы. Он считается самым быстрым классификатором, хорошо масштабируется и обрабатывает как дискретные, так и непрерывные данные. Этот алгоритм используется для прогнозирования в режиме реального времени. Существуют различные типы наивного классификатора: многозначный наивный байесовский, Бернулли наивный байесовский, гауссовский наивный.

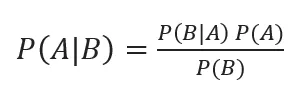

Байесовская классификация с апостериорными вероятностями определяется

Где A, B - события, P (A | B) - апостериорные вероятности.

Если два значения не зависят друг от друга, то

P (A, B) = P (A) P (B)

Наивный Байес может быть собран с использованием библиотеки Python. Наивные предсказатели являются независимыми, хотя они используются в системах рекомендаций. Они используются во многих приложениях в реальном времени и хорошо используются при классификации документов.

Преимущества:

Преимущества состоят в том, что они требуют очень меньшей вычислительной мощности, предполагаемой в задачах прогнозирования нескольких классов, точно работают с большими наборами данных.

Недостаток:

Основным недостатком этого классификатора является назначение нулевой вероятности. И у них есть особенности, которые не зависят друг от друга.

2) Дерево решений

Это нисходящая модель подхода со структурой блок-схемы обработки больших данных. Результаты прогнозируются на основе заданной входной переменной. Дерево решений состоит из следующих элементов: корень, множество узлов, ветвей, листьев. Корневой узел выполняет разбиение на основе значения атрибута класса, внутренний узел принимает атрибут для дальнейшей классификации, ветви принимают правило принятия решения о разбиении узлов на конечные узлы, и, наконец, конечные узлы дают нам окончательный результат. Временная сложность дерева решений зависит от количества записей, атрибутов обучающих данных. Если дерево решений слишком длинное, трудно получить желаемый результат.

Преимущество: они применяются для прогнозной аналитики для решения проблем и используются в повседневной работе для выбора цели на основе анализа решений. Автоматически строит модель на основе исходных данных. Лучше всего обрабатывать пропущенные значения.

Недостаток: размер дерева не поддается контролю, пока у него нет некоторых критериев остановки. Из-за их иерархической структуры дерево нестабильно.

3) Машина опорных векторов

Этот алгоритм играет жизненно важную роль в задачах классификации и, наиболее часто, алгоритмах, контролируемых машинным обучением. Это важный инструмент, используемый исследователем и исследователем данных. Этот SVM очень прост, и его процесс заключается в поиске гиперплоскости в точках данных N-мерного пространства. Гиперплоскости - это границы принятия решений, которые классифицируют точки данных. Весь этот вектор падает ближе к гиперплоскости, максимально увеличивая границу классификатора. Если маржа максимальная, самая низкая ошибка обобщения. Их реализация может быть выполнена с помощью ядра с использованием Python с некоторыми наборами обучающих данных. Основной целью SVM является обучение объекта определенной классификации. SVM не ограничен, чтобы стать линейным классификатором. SVM предпочтительнее любой модели классификации из-за их функции ядра, которая повышает вычислительную эффективность.

Преимущество: они очень предпочтительны из-за их меньшей вычислительной мощности и эффективной точности. Эффективен в большом размерном пространстве, хорошая эффективность памяти.

Недостаток: ограничения по скорости, ядру и размеру

4) Случайный лес

Это мощный алгоритм машинного обучения, основанный на подходе к обучению Ensemble. Основным строительным блоком Случайного леса является дерево решений, используемое для построения прогнозных моделей. Демонстрация работы включает в себя создание леса случайных деревьев решений, и процесс сокращения выполняется путем установки разбивающих интервалов для получения лучшего результата. Случайный лес реализуется с использованием техники, называемой пакетирование для принятия решений. Такая упаковка предотвращает перегрузку данных за счет уменьшения смещения, аналогично этому случайная выборка может обеспечить более высокую точность. Окончательный прогноз принимается в среднем из множества деревьев решений, то есть частых прогнозов. Случайный лес включает в себя множество вариантов использования, таких как прогнозы фондового рынка, обнаружение мошенничества, прогнозы новостей.

Преимущества:

- Не требует большой обработки для обработки наборов данных и очень простой для построения модели. Обеспечивает большую точность помогает в решении прогнозных проблем.

- Хорошо работает при обработке пропущенных значений и автоматически обнаруживает выброс.

Недостаток:

- Требует высоких вычислительных затрат и большого объема памяти.

- Требуется гораздо больше времени.

5) K- Ближайшие соседи

Здесь мы обсудим алгоритм K-NN с контролируемым обучением для CART. Они используют K положительное маленькое целое число; объект присваивается классу на основе соседей, или мы будем говорить, назначая группу, наблюдая, в какой группе находится сосед. Это выбирается путем измерения расстояния евклидова расстояния и грубой силы. Значение K можно найти с помощью процесса настройки. KNN не предпочитает изучать какую-либо модель для обучения нового набора данных и использовать нормализацию для масштабирования данных.

Преимущество: дает эффективные результаты, если данные обучения огромны.

Недостаток: самая большая проблема в том, что если переменная мала, она работает хорошо. Во-вторых, выбор коэффициента К при классификации.

Вывод

В заключение, мы рассмотрели возможности различных алгоритмов классификации, все еще выступая в качестве мощного инструмента в проектировании функций, классификации изображений, которая играет большую роль для машинного обучения. Алгоритмы классификации - это мощные алгоритмы, которые решают сложные проблемы.

Рекомендуемые статьи

Это руководство по классификационным алгоритмам в машинном обучении. Здесь мы обсуждаем, что классификация может быть выполнена как на структурированных, так и на неструктурированных данных. Вы также можете просмотреть наши другие предлагаемые статьи -

- Алгоритмы маршрутизации

- Алгоритм кластеризации

- Процесс добычи данных

- Алгоритмы машинного обучения

- Наиболее используемые техники ансамблевого обучения

- С ++ Алгоритм | Примеры алгоритма C ++