Разница между Hadoop и SQL

Огромные данные, генерируемые каждую секунду через социальные сети, такие как Facebook, Twitter, Instagram, проложили путь к развитию Hadoop / Big Data Ecosystem. Термин «3 В», относящийся к громкости, скорости и скорости, определяет важность Hadoop для обработки потоковых данных. Сегодня данные генерируются из нескольких источников, которые необходимо интегрировать для различных целей, таких как отчетность, анализ данных и исследования, а также для централизованного хранения данных. Когда мы делаем это, возникают многочисленные проблемы с традиционными подходами, такими как пространство, доступ, целостность, структура и пропускная способность. Для решения всех этих проблем Hadoop предоставляет платформу, которая позволяет обрабатывать данные огромного размера, обеспечивать легкий доступ, высокую доступность и динамическую загрузку данных. Он имеет структуру распределенной файловой системы (HDFS) для хранения данных и встроенный процессор запросов, называемый «Map Reduce» для анализа и обработки данных, хранящихся в HDFS.

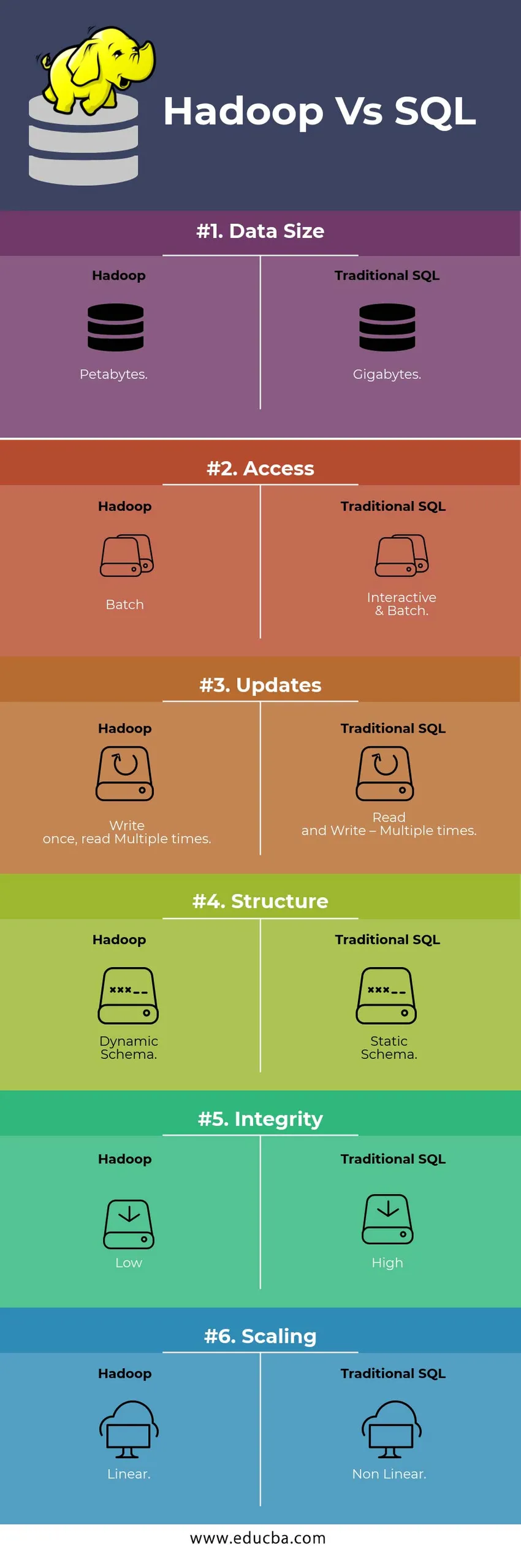

Сравнение HEAD TO HEAD между Hadoop и SQL

Ниже приведены 6 основных различий между Hadoop и SQL.

Ключевые различия между Hadoop и SQL

Ниже приведены различия между Hadoop и SQL:

- Схема на ПИСЬМО против ЧТЕНИЯ

Как правило, в традиционной базе данных при загрузке / переносе данных из одной базы данных в другую используется схема записи. Это приводит к тому, что процесс загрузки данных возбуждается / прерывается и приводит к отклонению записей из-за различий в структуре исходной и целевой таблиц, тогда как в системе Hadoop все данные хранятся в HDFS, а данные централизованы.

Hadoop Framework в основном используется для процесса анализа данных. Таким образом, он поддерживает все три категории данных, то есть структурированные, полуструктурированные и неструктурированные данные, и позволяет использовать схему при чтении.

- Структурированные данные имеют определенный формат. г .: XML-файл.

- Полуструктурные данные слабее; Может иметь / не иметь схему. г .: электронная таблица

- Неструктурированные данные не имеют определенной структуры или схемы. Например: обычный текст или изображение.

Hadoop эффективно работает с неструктурированными данными, поскольку он способен интерпретировать данные во время обработки.

| Подходить | преимущество | Недостаток |

| Схема при записи | · Предварительно определенные структуры

· Быстрее читать. Например: традиционные СУБД. | Медленная загрузка данных

Высокая задержка |

| Схема на чтение | · Динамическая структура

· Быстрое написание и чтение. Например: Hadoop | Быстрая загрузка данных

Низкая задержка |

Таблица : Схема на WRITE VS Схема на READ.

- Масштабируемость и стоимость

Hadoop Framework предназначен для обработки большого объема данных. Всякий раз, когда размер данных увеличивается, ряд дополнительных ресурсов, таких как узел данных, может быть добавлен в кластер очень легко, чем традиционный подход статического распределения памяти. Время и бюджет относительно очень малы для их реализации, а также Hadoop предоставляет Data Locality, где данные доступны в узле, выполнившем задание.

- ОТКАЗОУСТОЙЧИВОСТЬ

В традиционной СУБД, когда данные теряются из-за повреждения или любой проблемы с сетью, требуется больше времени, затрат и ресурсов, чтобы вернуть потерянные данные. Но в Hadoop есть механизм, в котором данные имеют минимум три уровня коэффициента репликации для данных, хранящихся в HDFS. Если один из узлов данных, который содержит данные, выходит из строя, данные могут быть легко извлечены из других узлов данных с высокой доступностью данных. Следовательно, делает данные легкодоступными для пользователя независимо от любого сбоя.

- ФУНКЦИОНАЛЬНОЕ ПРОГРАММИРОВАНИЕ

Hadoop поддерживает написание функционального программирования на таких языках, как Java, Scala и Python. Для любого приложения, которое требует каких-либо дополнительных функций, можно реализовать, зарегистрировав UDF-пользовательские функции в HDFS. В RDBMS нет возможности написания UDF, и это увеличивает сложность написания SQL. Более того, к данным, хранящимся в HDFS, могут обращаться все экосистемы Hadoop, такие как Hive, Pig, Sqoop и HBase. Таким образом, если UDF написан, он может использоваться любым из вышеупомянутых приложений. Это повышает производительность и поддержку системы.

- ОПТИМИЗАЦИЯ

Hadoop хранит данные в HDFS и Process через Map Reduce с помощью огромных методов оптимизации. Наиболее популярные методы, используемые для обработки данных, - это использование разбиения и хранения данных. Разделение - это подход для хранения данных в HDFS путем разделения данных на основе столбца, упомянутого для разделения. Когда данные вводятся или загружаются в HDFS, он идентифицирует столбец раздела и помещает данные в соответствующий каталог раздела. Таким образом, запрос извлекает набор результатов, непосредственно выбирая данные из многораздельного каталога. Это уменьшает сканирование всей таблицы, улучшает время отклика и позволяет избежать задержки.

Другой подход называется группированием данных. Это позволяет аналитику легко распределять данные между узлами данных. Все узлы будут иметь одинаковое количество распределенных данных. Столбец с разбивкой выбирается таким образом, чтобы он имел наименьшее количество элементов.

Эти подходы недоступны в традиционном методе SQL.

- ТИП ДАННЫХ

В традиционном подходе поддерживаемый тип данных очень ограничен. Он поддерживает только структурированные данные. Таким образом, для очистки и форматирования самой схемы данных потребуется больше времени. Но Hadoop поддерживает сложные типы данных, такие как Array, Struct и Map. Это поощряет использование различных типов наборов данных, которые будут использоваться для загрузки данных. Например: данные XML могут быть загружены путем определения данных с помощью элементов XML, содержащих сложный тип данных.

- СЖАТИЕ ДАННЫХ

Для традиционной системы баз данных доступно гораздо меньше встроенных методов сжатия. Но для среды Hadoop существует много методов сжатия, таких как gzib, bzip2, LZO и snappy. Режим сжатия по умолчанию - LZ4. Даже таблицы могут быть сжаты с использованием таких методов сжатия, как Parquet, ORC. Методы сжатия помогают сделать таблицы занимающими очень мало места, увеличивая пропускную способность и ускоряя выполнение запросов.

Сравнительная таблица Hadoop и SQL

| Характеристики | Традиционный SQL | Hadoop |

| Размер данных | гигабайт | петабайт |

| Доступ | Интерактивный и пакетный | партия |

| Обновления | Чтение и запись - несколько раз | Написать один раз, прочитать несколько раз |

| Структура | Статическая Схема | Динамическая Схема |

| целостность | Высоко | Низкий |

| пересчет | Нелинейная | линейный |

Таблица : Сравнение между традиционным Hadoop и SQL Framework.

Вывод - Hadoop против SQL

В целом, Hadoop опережает традиционный SQL с точки зрения затрат, времени, производительности, надежности, поддержки и доступности данных для очень большой группы пользователей. Для эффективной обработки огромного количества данных, генерируемых каждый день, инфраструктура Hadoop помогает своевременно собирать, хранить, обрабатывать, фильтровать и, наконец, хранить в ней в централизованном месте.

Рекомендуемая статья

- Hadoop vs Hive - узнай лучшие отличия

- Узнайте 10 полезных отличий Hadoop от Redshift

- HADOOP vs RDBMS | Знай 12 полезных отличий

- Apache Hadoop против Apache Spark | 10 лучших сравнений, которые вы должны знать!

- Hadoop vs Spark: особенности