Что такое Apache Hadoop Ecosystem?

Apache Hadoop Ecosystem - это платформа или платформа данных с открытым исходным кодом, предназначенная для сохранения и изучения огромных коллекций неструктурированных данных. Во всем мире существует тонна данных, поступающих с многочисленных цифровых платформ с использованием передовых инновационных технологий больших данных. Более того, Apache Hadoop был первым, кто получил этот поток инноваций.

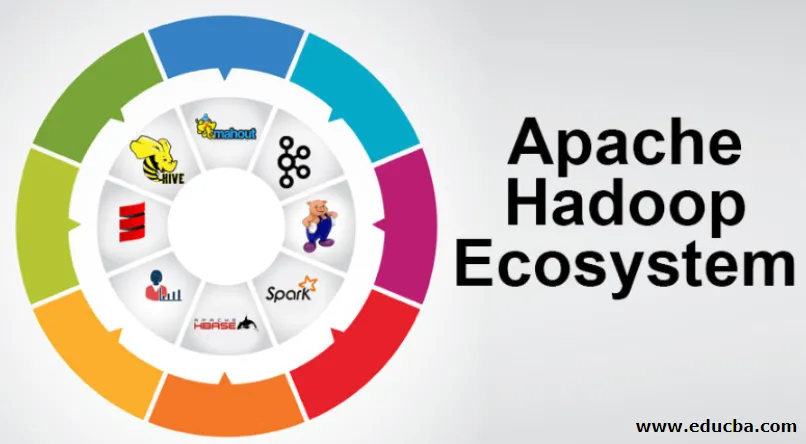

Что входит в состав архитектуры / экосистемы Hadoop Data?

Экосистема Hadoop - это не язык программирования или сервис, это платформа или платформа, которая решает проблемы больших данных. Вы можете идентифицировать его как набор, который охватывает различные сервисы, такие как хранение, прием внутрь, обслуживание и анализ внутри него. Затем изучите и получите краткую мысль о том, как сервисы работают исключительно и в сотрудничестве. Архитектура Apache Hadoop состоит из различных инноваций и элементов Hadoop, благодаря которым даже сложные информационные проблемы могут быть эффективно решены.

Ниже приводится описание каждой части:

1) Наменоде: направляет процесс информации

2) Datanode: собирает информацию для локального хранения. Не рекомендуется постоянно сохранять всю информацию в единственном месте, так как это может привести к потере информации в случае перебоев.

3) Отслеживание задач: они получают обязанности, назначенные подчиненному узлу.

4) Карта: она берет информацию из потока и обрабатывает каждую строку, разделяя ее на разные поля

5) Уменьшить: здесь поля, полученные с помощью карты, собираются или связаны друг с другом

Apache Hadoop Ecosystem - шаг за шагом

Каждый элемент экосистемы Hadoop, как и конкретные аспекты, очевиден. Комплексный взгляд на структуру Hadoop предлагает замечательное качество для распределенных файловых систем Hadoop (HDFS), Hadoop YARN, Hadoop MapReduce и Hadoop MapReduce из экосистемы Hadoop. Hadoop даже предоставляет каждую библиотеку Java, важные записи Java, отражение на уровне ОС, преимущества и сценарии для работы с Hadoop. Hadoop YARN - это метод бизнес-планирования и управления ресурсами. В конфигурации Hadoop HDFS обеспечивает высокую пропускную способность для передачи информации о приложении, а Hadoop MapReduce обеспечивает параллельную подготовку обширного ассортимента данных на основе YARN.

Обзор экосистемы Apache Hadoop

Это фундаментальный вопрос для понимания, прежде чем вы начнете работать с экосистемой Hadoop. Ниже приведены основные компоненты:

- HDFS: это центральная часть экосистемы Hadoop, которая может сохранять огромное количество неструктурированной, структурированной и полуструктурированной информации.

- YARN: Это напоминает разум экосистемы Hadoop, и вся обработка выполняется непосредственно здесь, что может включать распределение активов, планирование работы и подготовку действий.

- MapReduce: представляет собой смесь двух процессов, описанных как Map и Reduce, и состоит из основных частей, составляющих огромные информационные коллекции с использованием параллельных и рассредоточенных алгоритмов внутри экосистемы Hadoop.

- Apache Pig: это язык процедуры, который используется для параллельной обработки приложений для обработки обширных информационных коллекций в состоянии Hadoop, и этот язык является опцией для программирования на Java.

- HBase: это база данных с открытым исходным кодом и не связанная с ней или база данных NoSQL. Он поддерживает все типы информации и, следовательно, может работать с любым типом информации в рамках Hadoop.

- Mahout, Spark MLib: Mahout используется для машинного обучения и дает природу для создания приложений машинного обучения.

- Zookeeper: Чтобы иметь дело с группами, можно использовать Zookeeper, иначе он называется лордом координации, который может обеспечить надежное, быстрое и разобрано оперативное администрирование для групп Hadoop.

- Oozie: Apache Oozie управляет рабочим графиком и работает как служба оповещения и синхронизации внутри экосистемы Hadoop.

- Амбари: Это задача Apache Software Foundation, и она может обеспечить гибкость экосистемы Hadoop.

Hadoop YARN:

Думайте о YARN как о уме вашей экосистемы Hadoop. Он воспроизводит всю вашу обработку, распределяя активы и обязанности по планированию.

У этого есть два заслуживающих внимания сегмента, которые являются ResourceManager и NodeManager.

- ResourceManager: - Это снова главный узел в операционном подразделении. Он получает подготовительные запросы и после этого передает запросы соответствующим родственникам NodeManager соответственно, где происходит подлинная обработка.

- NodeManagers: - Они установлены на каждом DataNode. Он отвечает за выполнение назначения для каждого и каждого DataNode.

Как работает Apache Hadoop?

- Он предназначен для перехода от отдельных серверов к огромному количеству машин, каждая из которых обеспечивает локальные вычисления и емкость. Вместо того, чтобы полагаться на оборудование для обеспечения высокой доступности, сама библиотека предназначена для того, чтобы распознавать и справляться с разочарованиями на прикладном уровне, обеспечивая таким образом чрезвычайно доступную услугу на множестве ПК, каждый из которых может быть склонен к разочарованиям.

- Посмотрите дальше, однако, и там значительно увеличивается очарование на работе. Hadoop является полностью модульным, что означает, что вы можете заменить практически любой из его сегментов на альтернативный программный инструмент. Это делает архитектуру фантастически адаптируемой, такой же мощной и эффективной.

Apache Hadoop Spark:

- Apache Spark - это система для анализа информации в реальном времени в условиях распределенных вычислений. Он реализует вычисления в памяти для увеличения скорости обработки информации.

- Он быстрее обрабатывает обширную информацию, поскольку использует вычисления в памяти и различные улучшения. Вдоль этих линий, это требует высокой обрабатывающей силы.

Как работает Apache Pig?

- Apache Pig - это полезная система, разработанная Yahoo для эффективного и беспроблемного изучения огромных информационных позиций. Он предоставляет некоторый высокоуровневый язык информационных потоков Pig Latin, который является расширенным, расширяемым и простым в использовании.

- Исключительный компонент программ Свинья, в которых их состав доступен для существенного распараллеливания, делает это простым для заботы о существенных информационных коллекциях.

Вариант использования свиньи:

- Информация о частном здравоохранении является частной и не должна передаваться другим людям. Эти данные должны быть скрыты, чтобы сохранить секретность, однако информация о медицинских услугах настолько велика, что признание и исключение индивидуальной медицинской информации крайне важно. Apache Pig может использоваться в таких условиях для отмены распознавания данных о состоянии здоровья.

Вывод:

- Планируется подняться от одного сервера до огромного количества машин, обеспечивающих вычислительные возможности и производительность. Однако смотрите дальше, и на работе появляется все больше чар.

- Hadoop является полностью модульным, что означает, что вы можете обменять практически любую его часть на альтернативный программный инструмент. Это делает структуру фантастически адаптируемой, такой же мощной и эффективной.

Рекомендуемые статьи

Это руководство по экосистеме Apache Hadoop. Здесь мы обсудим, что такое Apache Hadoop Ecosystem? обзор архитектуры Hadoop и работы экосистемы Hadoop. Вы также можете просмотреть наши другие предлагаемые статьи, чтобы узнать больше -

- Компоненты экосистемы Hadoop

- Как установить Apache

- Обучение Apache Spark

- Карьера в Hadoop