Введение в методы ядра в машинном обучении

Алгоритм, используемый для анализа паттернов, называется методом ядра в машинном обучении. В общем, анализ проводится для поиска связей в наборах данных. Этими отношениями могут быть кластеризация, классификация, главные компоненты, корреляция и т. Д. Большинство из этих алгоритмов, которые решают эти задачи анализа шаблона, нуждаются в данных в необработанном представителе, чтобы явным образом преобразовать их в вектор признаков. Это преобразование может быть выполнено через пользовательскую карту объектов. Таким образом, можно предположить, что для метода ядра требуется только ядро, указанное пользователем.

Терминология Kernal Method основана на том факте, что они используют функцию ядра, которая позволяет им выполнять операции в многомерном, неявном пространстве признаков без необходимости вычисления координат данных в этом пространстве. Вместо этого они просто вычисляют внутренний продукт между изображениями всех пар данных в пространстве признаков.

Эти виды операций в большинстве случаев дешевле в вычислительном отношении по сравнению с явным вычислением координат. Эта техника называется «трюк с ядром». Любую линейную модель можно преобразовать в нелинейную модель, применив к модели трюк ядра.

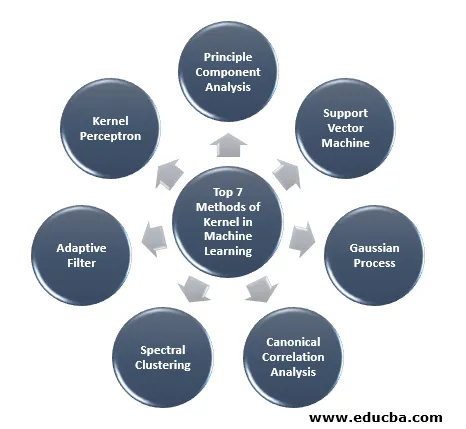

Методом ядра, доступным в машинном обучении, является анализ главных компонентов (PCA), спектральная кластеризация, машины опорных векторов (SVM), канонический корреляционный анализ, персептрон ядра, процессы Гаусса, регрессия гребня, линейные адаптивные фильтры и многие другие. Давайте иметь общее представление о некоторых из этих методов ядра.

Топ 7 методов ядра в машинном обучении

Вот методы ядра в машинном обучении, упомянутые ниже:

1. Принципиальный компонент анализа

Анализ основных компонентов (PCA) - это метод извлечения структуры из, возможно, многомерных наборов данных. Это легко выполнить с помощью итерационных алгоритмов, которые оценивают главные компоненты, или путем решения проблемы собственных значений. PCA - это ортогональное преобразование системы координат, в которой мы описываем наши данные. Новая система координат получается путем проекции на главные оси данных. Небольшое количество основных компонентов часто достаточно для учета большей части структуры данных. Одним из его основных применений является проведение аналитического анализа данных для создания прогнозной модели. В основном он используется для визуализации взаимосвязи между популяциями и генетической дистанции.

2. Опорная векторная машина

SVM может быть определен как классификатор для разделения гиперплоскости, где гиперплоскость является подпространством одного измерения меньше, чем окружающее пространство. Размерность этого математического пространства определяется как минимальное количество координат, необходимое для указания любой точки, тогда как окружающее пространство - это пространство, которое окружает математический объект. Теперь математический объект можно понимать как абстрактный объект, который не существует ни в какое время или в каком-либо месте, но существует как тип вещи.

3. Гауссовский процесс

Гауссовский процесс был назван в честь Карка Фридриха Гаусса, потому что он использует обозначение гауссовского распределения (нормальное распределение). Это случайный процесс, который означает набор случайных величин, проиндексированных по времени или пространству. В Гауссовском процессе случайные переменные имеют многомерное нормальное распределение, то есть все конечные линейные комбинации его нормально распределены. Гауссовский процесс использует свойства, унаследованные от нормального распределения, и, следовательно, полезен при статистическом моделировании. Алгоритм машинного обучения, использующий этот метод ядра, использует меру ленивого обучения и сходство между точками, чтобы предсказать ценность невидимых точек из обучающих данных. Этот прогноз является не только оценкой, но и неопределенностью в этой точке.

4. Канонический корреляционный анализ

Канонический корреляционный анализ - это способ получения информации из кросс-ковариационных матриц. Он также известен как анализ канонических переменных. Предположим, у нас есть два вектора X, Y случайной величины, скажем, два вектора X = (X1, …, Xn) и вектор Y = (Y1, …, Ym), и переменная, имеющая корреляцию, тогда CCA вычислит линейную комбинацию X и Y, который имеет максимальную корреляцию между собой.

5. Спектральная кластеризация

В применении сегментации изображения спектральная кластеризация известна как категоризация объектов на основе сегментации. В спектральной кластеризации уменьшение размерности выполняется перед кластеризацией в меньшем количестве измерений, это делается с использованием собственного значения матрицы подобия данных. Он имеет свои корни в теории графов, где этот подход используется для идентификации сообществ узлов в графе, который основан на ребрах, соединяющих их. Этот метод достаточно гибок и позволяет нам кластеризовать данные и из неграфа.

6. Адаптивный фильтр

Адаптивный фильтр использует линейный фильтр, который содержит передаточную функцию, которая управляется переменными параметрами и методами, которые будут использоваться для настройки этих параметров в соответствии с алгоритмом оптимизации. Сложность этого алгоритма оптимизации является причиной того, что все адаптивные фильтры являются цифровыми фильтрами. Адаптивный фильтр необходим в тех приложениях, где нет предварительной информации о желаемой операции обработки или они меняются.

Функция стоимости используется в адаптивном фильтре с обратной связью, поскольку она необходима для оптимальной работы фильтра. Он определяет, как изменить функцию переноса фильтра, чтобы уменьшить стоимость следующей итерации. Одной из наиболее распространенных функций является среднеквадратичная ошибка сигнала ошибки.

7. Ядро Перцептрон

В машинном обучении ядро персептрон является типом популярного алгоритма обучения персептрона, который может изучать машины ядра, такие как нелинейные классификаторы, которые используют функцию ядра для вычисления подобия тех выборок, которые не видны обучающим выборкам. Этот алгоритм был изобретен в 1964 году, что сделало его первым учеником по классификации ядра.

Большинство обсуждаемых алгоритмов ядра основаны на выпуклой оптимизации или собственных задачах и являются статистически обоснованными. Их статистические свойства анализируются с использованием статистической теории обучения.

Говоря об областях применения методов ядра, он разнообразен и включает в себя геостатистику, кригинг, обратное взвешивание расстояний, трехмерную реконструкцию, биоинформатику, хемоинформатику, извлечение информации и распознавание рукописного ввода.

Вывод

Я суммировал некоторые термины и типы методов ядра в машинном обучении. Из-за нехватки места эта статья ни в коем случае не является всеобъемлющей и предназначена только для того, чтобы дать вам представление о том, что такое метод ядра, и краткую сводку их типов. Однако освещение этой статьи заставит вас сделать первый шаг в области машинного обучения.

Рекомендуемые статьи

Это руководство по методу ядра в машинном обучении. Здесь мы обсуждаем 7 типов методов ядра в машинном обучении. Вы также можете посмотреть на следующую статью.

- Монолитное ядро

- Кластеризация в машинном обучении

- Машинное обучение данным науки

- Неуправляемое машинное обучение

- PHP фильтры | Как проверить пользовательский ввод с использованием различных фильтров?

- Полное руководство по жизненному циклу машинного обучения