Введение в Hadoop Framework

Прежде чем мы углубимся в технические рамки Hadoop, мы начнем с простого примера.

Есть ферма, которая собирает помидоры и хранит их в едином хранилище, и теперь, когда растет спрос на овощи, ферма начала собирать картофель и морковь - по мере роста спроса возникла нехватка фермеров, поэтому они наняли больше фермеров. Через некоторое время они поняли, что в хранилище ощущается нехватка - поэтому они распределили овощи в разных хранилищах. Когда дело доходит до извлечения данных, все они работают параллельно с собственным пространством хранения.

Итак, как эта история связана с большими данными?

Ранее у нас были ограниченные данные, с ограниченным процессором и одним хранилищем. Но затем увеличилась генерация данных, что привело к большим объемам и различным разновидностям - структурированным, полуструктурированным и неструктурированным. Таким образом, решение заключалось в использовании распределенного хранилища для каждого процессора, что обеспечивало легкий доступ для хранения и доступа к данным.

Таким образом, теперь мы можем заменить овощи как различные виды данных и места хранения в качестве распределенных мест для хранения данных, и разные рабочие процессоры являются каждым процессором.

Таким образом, большие данные - это проблема, и Hadoop играет роль решения.

Hadoop

1. Решение для БОЛЬШИХ ДАННЫХ: поскольку оно имеет дело со сложностями большого объема, скорости и разнообразия данных.

2. Набор проекта с открытым исходным кодом.

3. Надежно хранит огромный объем данных и позволяет выполнять огромные распределенные вычисления.

4. Ключевыми атрибутами Hadoop являются избыточность и надежность (абсолютно без потери данных).

5. В первую очередь фокусируется на пакетной обработке.

6. Работает на обычном оборудовании - вам не нужно покупать какое-либо специальное дорогое оборудование.

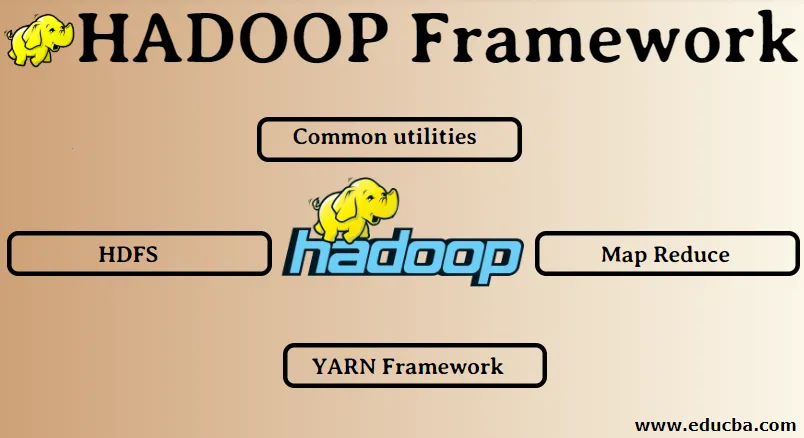

Hadoop Framework:

1. Общие коммунальные услуги

2. HDFS

3. Карта Уменьшить

4. YARN Framework

1. Общие утилиты:

Также называется общим Hadoop. Это не что иное, как библиотеки, файлы, сценарии и утилиты JAVA, которые фактически требуются для работы других компонентов Hadoop.

2. HDFS: распределенная файловая система Hadoop

Почему Hadoop решил использовать распределенную файловую систему?

Давайте разберемся с этим на примере: нам нужно прочитать 1 ТБ данных, и у нас есть одна машина с 4 каналами ввода-вывода, каждый канал имеет скорость 100 МБ / с, чтение всех данных заняло 45 минут. Теперь один и тот же объем данных читается 10 машинами с 4 каналами ввода / вывода, каждый канал имеет скорость 100 МБ / с. Угадайте, сколько времени потребовалось, чтобы прочитать данные? 4, 3 минуты HDFS решает проблему хранения больших данных. Двумя основными компонентами HDFS являются NAME NODE и DATA NODE. Узел имени является главным, у нас также может быть вторичный узел имени в случае, если первичный узел имени перестает работать, вторичный узел имени будет действовать в качестве резервной копии. Узел имени в основном поддерживает и управляет узлами данных путем хранения метаданных. Узел данных - это ведомое устройство, которое в основном является недорогим товарным оборудованием. Мы можем иметь несколько узлов данных. Узел данных хранит фактические данные. Этот узел данных поддерживает коэффициент репликации. Предположим, что если один узел данных выйдет из строя, то другой узел реплицированных данных сможет получить доступ к данным, следовательно, доступность данных улучшится, а потеря данных будет предотвращена.

3. Карта Уменьшить:

Это решает проблему обработки больших данных. Давайте разберемся с концепцией карты, которая сводится к решению этой реальной проблемы. Компания ABC хочет рассчитать общий объем продаж по городу. Теперь здесь концепция хеш-таблицы не будет работать, потому что данные в терабайтах, поэтому мы будем использовать концепцию Map-Reduce.

Есть две фазы: а) MAP. б) СНИЖЕНИЕ

а) Карта : сначала мы разделим данные на более мелкие порции, называемые мапперами, на основе пары ключ / значение. Поэтому здесь ключом будет название города, а значением будет общий объем продаж. Каждый картограф будет получать данные за каждый месяц, которые дают название города и соответствующие продажи.

б) Сокращение: он получит эти кучи данных, и каждый редуктор будет отвечать за города Север / Запад / Восток / Юг. Таким образом, работа редуктора будет собирать эти маленькие куски и преобразовывать их в большие суммы (складывая их) для конкретного города.

4. YARN Framework: еще один ресурсный переговорщик.

Первоначальная версия Hadoop состояла из двух компонентов: Map Reduce и HDFS. Позже выяснилось, что Map Reduce не может решить множество проблем с большими данными. Идея заключалась в том, чтобы убрать обязанности по управлению ресурсами и планированию заданий от старого механизма map-Reduce и передать его новому компоненту. Вот так вот как на фото появился YARN. Это средний уровень между HDFS и Map Reduce, который отвечает за управление ресурсами кластера.

Он выполняет две ключевые роли: а) Планирование работы. б) управление ресурсами

а) Планирование работы: когда большой объем данных отдается для обработки, его необходимо распределить и разбить на различные задачи / задания. Теперь JS решает, какому заданию должен быть присвоен высший приоритет, интервал времени между двумя заданиями, зависимость между заданиями, проверяет, нет ли перекрытия между запущенными заданиями.

б) Управление ресурсами: для обработки данных и для хранения данных нам нужны ресурсы правильно? Таким образом, менеджер ресурсов предоставляет, управляет и поддерживает ресурсы для хранения и обработки данных.

Итак, теперь мы понимаем концепцию Hadoop и то, как она решает проблемы, создаваемые БОЛЬШИМИ ДАННЫМИ !!!

Рекомендуемые статьи

Это было руководство по Hadoop Framework. Здесь мы также обсудим 4 лучших фреймворка Hadoop. Вы также можете просмотреть наши другие предлагаемые статьи, чтобы узнать больше -

- База данных Hadoop

- Экосистема Hadoop

- Использование Hadoop

- Работа администратора Hadoop

- Администратор Hadoop | Навыки и карьера